ฟังก์ชันไปป์ไลน์ () เป็นส่วนสำคัญของไลบรารี Transformer ต้องใช้อินพุตหลายตัวเพื่อให้เราสามารถกำหนดงานการอนุมาน โมเดล กลไกโทเค็นไนเซชัน ฯลฯ ฟังก์ชันไปป์ไลน์ () ถูกใช้เป็นหลักเพื่อดำเนินงาน NLP บนข้อความเดียวหรือหลายข้อความ โดยจะทำการประมวลผลล่วงหน้ากับอินพุตและหลังการประมวลผลตามแบบจำลองเพื่อสร้างเอาต์พุตที่มนุษย์สามารถอ่านได้และการทำนายที่แม่นยำพร้อมความแม่นยำสูงสุด

บทความนี้ครอบคลุมประเด็นต่อไปนี้:

ไลบรารีชุดข้อมูล Hugging Face คืออะไร

ไลบรารีชุดข้อมูล Hugging Face เป็น API ที่ประกอบด้วยชุดข้อมูลสาธารณะหลายชุด และให้วิธีการดาวน์โหลดที่ง่ายดาย ไลบรารีนี้สามารถนำเข้าและติดตั้งลงในแอปพลิเคชันได้โดยใช้ปุ่ม “ ปิ๊ป ' สั่งการ. สำหรับการสาธิตการใช้งานจริงในการดาวน์โหลดและติดตั้งชุดข้อมูลของไลบรารี Hugging Face โปรดไปที่นี้ ลิงก์ Google Colab คุณสามารถดาวน์โหลดชุดข้อมูลหลายชุดได้จาก ฮับชุดข้อมูลใบหน้ากอด

เรียนรู้เพิ่มเติมเกี่ยวกับการทำงานของฟังก์ชันไปป์ไลน์ () โดยอ้างอิงจากบทความนี้ “ จะใช้ฟังก์ชัน Pipeline() ใน Transformers ได้อย่างไร? '.

จะใช้ Pipelines บนชุดข้อมูลใน Hugging Face ได้อย่างไร

Hugging Face มีชุดข้อมูลสาธารณะที่แตกต่างกันหลายชุดที่สามารถติดตั้งได้อย่างง่ายดายโดยใช้โค้ดบรรทัดเดียว ในบทความนี้ เราจะดูการสาธิตการใช้งานไปป์ไลน์กับชุดข้อมูลเหล่านี้ในทางปฏิบัติ มีสองวิธีที่สามารถนำไปป์ไลน์ไปใช้กับชุดข้อมูลได้

วิธีที่ 1: การใช้วิธีการวนซ้ำ

ฟังก์ชันไปป์ไลน์() สามารถวนซ้ำบนชุดข้อมูลและโมเดลได้เช่นกัน เพื่อจุดประสงค์นี้ ให้ทำตามขั้นตอนที่กล่าวถึงด้านล่าง:

ขั้นตอนที่ 1: ติดตั้ง Transformer Library

ในการติดตั้งไลบรารี Transformer ให้ระบุคำสั่งต่อไปนี้:

!pip ติดตั้งหม้อแปลง

ขั้นตอนที่ 2: นำเข้าไปป์ไลน์

เราสามารถนำเข้าไปป์ไลน์จากไลบรารี Transformer เพื่อจุดประสงค์นี้ ให้จัดเตรียมคำสั่งต่อไปนี้:

จากไปป์ไลน์นำเข้าหม้อแปลงไฟฟ้า

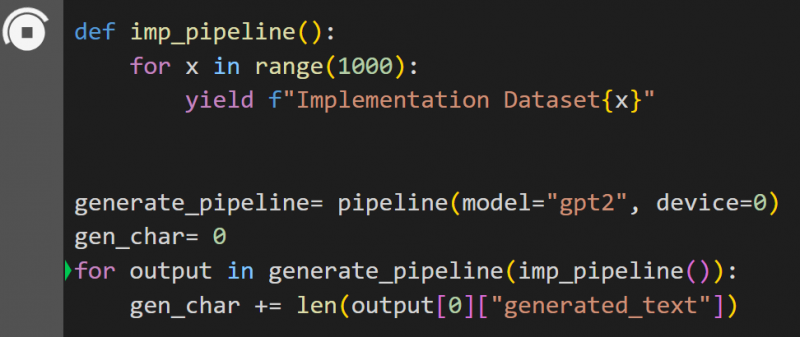

ขั้นตอนที่ 3: ใช้ไปป์ไลน์

ที่นี่ ฟังก์ชันไปป์ไลน์() ถูกนำไปใช้กับโมเดล “ GPT2 '. คุณสามารถดาวน์โหลดโมเดลได้จาก กอดใบหน้าโมเดลฮับ:

def imp_pipeline ():สำหรับ x อยู่ในช่วง (1,000):

ให้ผลตอบแทน f 'ชุดข้อมูลการใช้งาน {x}'

Generate_pipeline= ไปป์ไลน์ (รุ่น = 'gpt2', อุปกรณ์ = 0)

gen_char= 0

สำหรับเอาต์พุตใน Generate_pipeline(imp_pipeline()):

gen_char += len (เอาต์พุต [0] ['generated_text'])

ในรหัสนี้ “ Generate_pipeline ” เป็นตัวแปรที่มีฟังก์ชันไปป์ไลน์() พร้อมโมเดล “ GPT2 '. เมื่อถูกเรียกด้วย “ imp_ไปป์ไลน์() ” จะจดจำข้อมูลที่เพิ่มขึ้นโดยอัตโนมัติตามช่วงที่ระบุเป็น 1,000:

การดำเนินการนี้จะใช้เวลาพอสมควรในการฝึกอบรม ลิงค์ไปยัง บริษัท กูเกิล ก็ได้รับเช่นกัน

วิธีที่ 2: การใช้ไลบรารีชุดข้อมูล

ในวิธีนี้ เราจะสาธิตการใช้งานไปป์ไลน์โดยใช้ไลบรารี “ชุดข้อมูล”:

ขั้นตอนที่ 1: ติดตั้งหม้อแปลงไฟฟ้า

ในการติดตั้งไลบรารี Transformer ให้ระบุคำสั่งต่อไปนี้:

!pip ติดตั้งหม้อแปลง

ขั้นตอนที่ 2: ติดตั้งไลบรารีชุดข้อมูล

เนื่องจาก “ ชุดข้อมูล ” ไลบรารีประกอบด้วยชุดข้อมูลสาธารณะทั้งหมด เราสามารถติดตั้งได้โดยใช้คำสั่งต่อไปนี้ โดยการติดตั้ง “ ชุดข้อมูล ” ไลบรารี่ เราสามารถนำเข้าชุดข้อมูลใด ๆ ได้โดยตรงโดยระบุชื่อ:

!pip ติดตั้งชุดข้อมูล

ขั้นตอนที่ 3: ไปป์ไลน์ชุดข้อมูล

หากต้องการสร้างไปป์ไลน์บนชุดข้อมูล ให้ใช้โค้ดต่อไปนี้ KeyDataset เป็นคุณลักษณะที่ส่งออกเฉพาะค่าที่ผู้ใช้สนใจ:

จาก Transformers.pipelines.pt_utils นำเข้า KeyDatasetจากไปป์ไลน์นำเข้าหม้อแปลงไฟฟ้า

จากชุดข้อมูลนำเข้า load_dataset

gen_pipeline = ไปป์ไลน์ (model = 'hf-internal-testing/tiny-random-wav2vec2', อุปกรณ์ = 0)

loaddataset = load_dataset('hf-internal-testing/librispeech_asr_dummy', 'clean', split='validation[:10]')สำหรับเอาต์พุตใน gen_pipeline (KeyDataset (loaddataset, 'audio')):

print('กำลังพิมพ์ตอนนี้')

พิมพ์ ('----------------')

พิมพ์ (เอาท์พุท)

ผลลัพธ์ของโค้ดข้างต้นได้รับด้านล่าง:

นั่นคือทั้งหมดจากคู่มือนี้ ลิงค์ไปยัง บริษัท กูเกิล ถูกกล่าวถึงในบทความนี้ด้วย

บทสรุป

หากต้องการใช้ไปป์ไลน์กับชุดข้อมูล เราสามารถวนซ้ำชุดข้อมูลได้โดยใช้ฟังก์ชันไปป์ไลน์ () หรือใช้คำสั่ง “ ชุดข้อมูล ' ห้องสมุด. Hugging Face มอบลิงก์พื้นที่เก็บข้อมูล GitHub ให้กับผู้ใช้สำหรับทั้งชุดข้อมูลและโมเดลซึ่งสามารถใช้งานได้ตามความต้องการ บทความนี้ได้ให้คำแนะนำที่ครอบคลุมเกี่ยวกับการใช้ไปป์ไลน์บนชุดข้อมูลใน Transformers