ไวยากรณ์:

ดังที่เราคุ้นเคยกับ ChatGPT เรารู้ว่าแพลตฟอร์มนี้เป็นของชุมชน Open AI และมีเครื่องมือ สถาปัตยกรรม API และเฟรมเวิร์กต่างๆ ที่เราสามารถนำมาใช้ในการปรับใช้แอปพลิเคชันของเราและโมเดลการประมวลผลภาษาธรรมชาติ Open AI นำเสนอ API ที่เราสามารถใช้โมเดล AI และ NLP ที่ได้รับการฝึกฝนล่วงหน้าใดๆ จากแพลตฟอร์ม Open AI และสามารถทำให้ใช้กับแอปพลิเคชันของเราได้ เช่น เพื่อคาดการณ์ข้อมูลตามเวลาจริง ในทำนองเดียวกัน GPT4All ยังให้ผู้ใช้รวมโมเดล AI ที่ผ่านการฝึกอบรมล่วงหน้าเข้ากับแอปพลิเคชันต่างๆ

โมเดล GPT4All ได้รับการฝึกโดยใช้ข้อมูลที่จำกัดเมื่อเทียบกับ ChatGPT นอกจากนี้ยังมีข้อ จำกัด ด้านประสิทธิภาพเมื่อเทียบกับ ChatGPT แต่อนุญาตให้ผู้ใช้ใช้ GPT ส่วนตัวบนฮาร์ดแวร์ในเครื่องและไม่ต้องการการเชื่อมต่อเครือข่ายใด ๆ ด้วยความช่วยเหลือของบทความนี้ เราจะได้รู้ว่าเราสามารถใช้โมเดล GPT4All ในสคริปต์ Python ได้อย่างไร เนื่องจาก GPT4All มีการเชื่อมโยงกับ Python อย่างเป็นทางการ ซึ่งหมายความว่าเราสามารถใช้และรวมโมเดล GPT4All ผ่านสคริปต์ Python ได้เช่นกัน

ทุกอย่างต้องใช้คำสั่งออนไลน์เพื่อติดตั้ง GPT4All สำหรับ Python IDE จากนั้น เราอาจรวมโมเดล AI ได้มากเท่ากับแอปพลิเคชันของเรา คำสั่งในการติดตั้ง GPT4All ใน Python มีดังต่อไปนี้:

$ pip ติดตั้ง gpt4all

ตัวอย่างที่ 1:

ในการเริ่มต้นใช้งานตัวอย่างนี้ เราจำเป็นต้องดาวน์โหลดและติดตั้ง Python ในระบบของเรา เวอร์ชันที่แนะนำของ Python คือ “เวอร์ชัน 3.7” หรือเวอร์ชันที่อยู่หลังเวอร์ชันนี้ อีกวิธีหนึ่งในการทำงานร่วมกับ Python เพื่อหลีกเลี่ยงขั้นตอนการติดตั้ง 'Python setup' ที่ยาวนานในระบบของเราคือการใช้ 'Google Colab' ซึ่งเป็นสภาพแวดล้อมบนคลาวด์สำหรับ Python เราสามารถเรียกใช้สภาพแวดล้อมนี้บนเว็บเบราว์เซอร์ใดก็ได้ และสามารถสร้างโมเดล AI และการเรียนรู้ของเครื่องได้ ตัวอย่างที่เราจะนำไปใช้ที่นี่ดำเนินการใน Google Colab

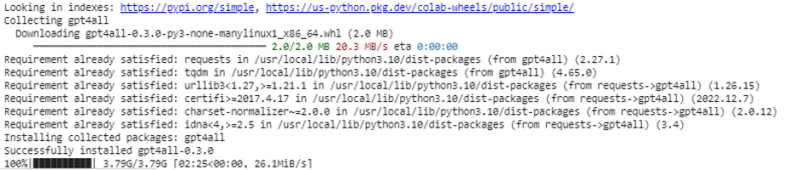

ตัวอย่างนี้ครอบคลุมวิธีการติดตั้ง GPT4All ใน Python และวิธีใช้โมเดลที่ฝึกไว้ล่วงหน้า เราเริ่มต้นด้วยการติดตั้ง GPT4All ก่อน สำหรับสิ่งนั้น คำสั่งที่เรากล่าวถึงก่อนหน้านี้จะถูกดำเนินการ ด้วยการเรียกใช้คำสั่ง GPT4All พร้อมกับแพ็คเกจและเฟรมเวิร์กจะถูกดาวน์โหลดและติดตั้ง

ตอนนี้เราก้าวไปข้างหน้า จาก GPT4All เรานำเข้า 'GPT4All' สิ่งนี้จะเพิ่มโมเดลที่ผ่านการฝึกอบรมล่วงหน้าทั้งหมดจาก GPT4All ไปยังโปรเจ็กต์ ตอนนี้ เราอาจใช้แบบจำลองเดียวและคาดการณ์สำหรับแอปพลิเคชันของเรา เมื่อเรานำเข้าแพ็คเกจ GPT4All แล้ว ก็ถึงเวลาเรียกใช้ฟังก์ชันนี้และใช้โมเดล GPT4All ซึ่งให้ผลลัพธ์สำหรับ 'การแชทเสร็จสิ้น'

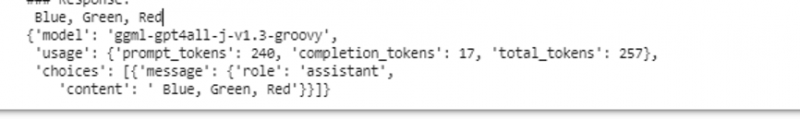

กล่าวอีกนัยหนึ่ง ถ้าเราถามอะไรจากโมเดลนั้นในอินพุต มันจะส่งกลับในเอาต์พุต โมเดลที่เราใช้คือ “ggml-gpt4all-j-v1.3-groovy” โมเดลเหล่านี้ถูกจัดเก็บไว้ในแคช GPT4All แล้ว เราสามารถรับโมเดลเหล่านี้ได้จากลิงค์นี้” https://github.com/nomic-ai/gpt4all/tree/main/gpt4all-chat ” สำหรับการดาวน์โหลดด้วยตนเอง หากโมเดลมีอยู่แล้วในแคช GPT4All เราก็เพียงเรียกชื่อโมเดลและระบุให้เป็นพารามิเตอร์อินพุตสำหรับฟังก์ชัน “GPT4All()” หากเราดาวน์โหลดด้วยตนเองได้สำเร็จ เราจะส่งเส้นทางไปยังโฟลเดอร์ที่มีโมเดลอยู่ เนื่องจากโมเดลนี้มีไว้สำหรับการกรอกข้อความ ไวยากรณ์สำหรับโมเดลนี้จึงมีดังต่อไปนี้:

$ Chat_completion (ข้อความ)ข้อความเป็นรายการพจนานุกรมและแต่ละพจนานุกรมควรมีคีย์ 'บทบาท' ที่มีค่าของผู้ใช้ ระบบ หรือผู้ช่วย และเนื้อหา 'คีย์' ซึ่งมีค่าเป็นสตริง ในตัวอย่างนี้ เราระบุเนื้อหาเป็น 'ชื่อสามสี' และกำหนดบทบาทเป็น 'ผู้ใช้'

$model= GPT4All('ggml-gpt4all-j-v1.3-groovy')$messages = [{'บทบาท': 'ผู้ใช้', 'เนื้อหา': 'ชื่อดอกไม้ 3 ดอก'}]

หลังจากข้อกำหนดนี้ เราจะเรียกฟังก์ชัน “chat_completion()” กับโมเดล รหัสสำหรับสิ่งนี้จะแสดงในผลลัพธ์ต่อไปนี้:

$ !pip ติดตั้ง gpt4allจาก gpt4all นำเข้า GPT4All

รุ่น = GPT4All('ggml-gpt4all-j-v1.3-groovy')

ข้อความ = [{'บทบาท': 'ผู้ใช้', 'เนื้อหา': 'ชื่อสามสี'}]

model.chat_completion (ข้อความ)

หลังจากดำเนินการตามตัวอย่างนี้ โมเดลจะส่งกลับสามสีเป็นการตอบสนองต่ออินพุต

ตัวอย่างที่ 2:

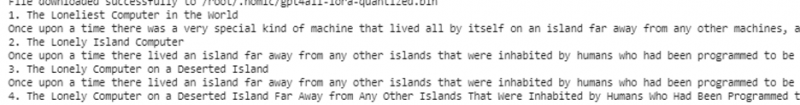

เราครอบคลุมตัวอย่างอื่นที่เราค้นพบวิธีอื่นในการใช้ GPT4All ใน Python ซึ่งสามารถทำได้โดยใช้การเชื่อมโยงอย่างเป็นทางการสำหรับ Python ซึ่งจัดทำโดย “Nomic” ซึ่งเป็นชุมชน AI แบบโอเพ่นซอร์ส และรัน GPT4All เราใช้คำสั่งต่อไปนี้เพื่อรวม 'nomic' เข้ากับคอนโซล Python ของเรา:

$ pip ติดตั้งชื่อย่อเมื่อติดตั้งแล้ว เราจะนำเข้า GPT4All จาก “nomic.gpt4all” หลังจากนำเข้า GPT4All แล้ว เราจะเริ่มต้น GPT4All ด้วยฟังก์ชัน “open()” จากนั้น เราเรียกฟังก์ชัน “prompt()” และส่งพรอมต์ไปยังฟังก์ชันนี้ จากนั้น การตอบกลับพร้อมท์จะถูกสร้างขึ้นตามพรอมต์ที่เราให้ไว้เป็นอินพุตกับโมเดลพรอมต์

!pip ติดตั้งชื่อจาก nomic.gpt4all นำเข้า GPT4All

# เริ่มต้นรุ่น GPT4All

เริ่มต้น = GPT4All()

เริ่มต้นเปิด ()

# สร้างการตอบสนองตามพรอมต์

model_response = initial.prompt('เขียนเรื่องสั้นเกี่ยวกับคอมพิวเตอร์)

# แสดงการตอบสนองที่สร้างขึ้น

พิมพ์ (model_response)

เอาต์พุตแสดงการตอบสนองพร้อมท์จากโมเดลที่เราสร้างขึ้นโดยใช้โมเดล GPT4All ที่ผ่านการฝึกอบรมล่วงหน้าใน Python หากเราต้องการทราบข้อมูลเพิ่มเติมเกี่ยวกับโมเดลและวิธีที่เราสามารถใช้โมเดลเหล่านี้เพื่อสร้างการตอบกลับ หรือพูดง่ายๆ ก็คือ หากเราต้องการได้รับความรู้เกี่ยวกับไวยากรณ์เพื่อสร้างการตอบกลับจากโมเดลเหล่านี้ เราอาจขอความช่วยเหลือเพิ่มเติมจาก รายละเอียดเอกสารทางเทคนิคของ GPT4All

บทสรุป

GPT4All ยังคงมุ่งมั่นที่จะได้รับประสิทธิภาพที่แม่นยำ ดำเนินการโดยแพลตฟอร์ม AI ชื่อดังซึ่งมีจุดมุ่งหมายเพื่อให้บริการแชทบอทอัจฉริยะเทียมแก่ผู้ใช้บน CPU ระดับผู้บริโภค เนื่องจาก GPT4All ทำงานโดยไม่ต้องเชื่อมต่อเครือข่ายและ GPU บทความนี้ให้ความรู้แก่เราในการใช้ PyGPT4All อย่างเชี่ยวชาญในสภาพแวดล้อม Python และเพื่อสร้างการโต้ตอบระหว่างแอปพลิเคชันของเรากับโมเดล AI ของ GPT4All ที่ผ่านการฝึกอบรมล่วงหน้า เราได้กล่าวถึงวิธีการติดตั้ง GPT4All ใน Python ไว้ 2 วิธีในคู่มือนี้