ในบล็อกนี้ เราจะเน้นไปที่วิธีที่คุณสามารถเพิ่มการใช้งาน GPU ใน PyTorch

จะเพิ่มการใช้งาน GPU ใน PyTorch ได้อย่างไร

มีเทคนิคหลายอย่างที่สามารถนำมาใช้เพื่อเพิ่มการใช้งาน GPU และรับรองว่าทรัพยากรฮาร์ดแวร์ที่ดีที่สุดจะถูกใช้สำหรับการประมวลผลโมเดลแมชชีนเลิร์นนิงที่ซับซ้อน กลยุทธ์เหล่านี้เกี่ยวข้องกับการแก้ไขโค้ดและการใช้คุณสมบัติ PyTorch คำแนะนำและเคล็ดลับที่สำคัญบางประการมีดังต่อไปนี้:

- กำลังโหลดข้อมูลและขนาดแบทช์

- โมเดลที่ใช้หน่วยความจำน้อยลง

- ไพทอร์ช ไลท์นิ่ง

- ปรับการตั้งค่ารันไทม์ใน Google Colab

- ล้างแคชเพื่อการเพิ่มประสิทธิภาพ

กำลังโหลดข้อมูลและขนาดแบทช์

“ ตัวโหลดข้อมูล ” ใน PyTorch ใช้เพื่อกำหนดข้อกำหนดของข้อมูลที่จะโหลดลงในโปรเซสเซอร์พร้อมกับการส่งต่อแต่ละครั้งของโมเดลการเรียนรู้เชิงลึก ที่ใหญ่กว่า” ขนาดชุด ” ของข้อมูลจะต้องใช้พลังการประมวลผลมากขึ้นและจะเพิ่มการใช้งาน GPU ที่มีอยู่

ไวยากรณ์สำหรับการกำหนด Dataloader ด้วยขนาดแบตช์เฉพาะใน PyTorch ให้กับตัวแปรที่กำหนดเองมีดังต่อไปนี้:

เพิ่ม_GPU_Utilization = DataLoader ( ชุด_ขนาด = 32 )

โมเดลที่ใช้หน่วยความจำน้อยลง

สถาปัตยกรรมแต่ละรุ่นต้องใช้ปริมาณ “ที่แตกต่างกัน” หน่วยความจำ ” เพื่อดำเนินการในระดับที่เหมาะสมที่สุด โมเดลที่มีประสิทธิภาพในการใช้หน่วยความจำน้อยกว่าต่อหน่วยเวลาสามารถทำงานกับขนาดแบตช์ที่ใหญ่กว่ารุ่นอื่นๆ มาก

ไพทอร์ช ไลท์นิ่ง

PyTorch มีเวอร์ชันลดขนาดลงนั่นคือ “ ไพทอร์ช ไลท์นิ่ง '. ได้รับการปรับให้เหมาะสมเพื่อประสิทธิภาพที่รวดเร็วปานสายฟ้าดังที่เห็นได้จากชื่อของมัน Lightning ใช้ GPU เป็นค่าเริ่มต้นและให้การประมวลผลที่เร็วกว่ามากสำหรับโมเดลการเรียนรู้ของเครื่อง ข้อได้เปรียบที่สำคัญของ Lightning คือการขาดข้อกำหนดสำหรับโค้ดสำเร็จรูปที่อาจขัดขวางการประมวลผล

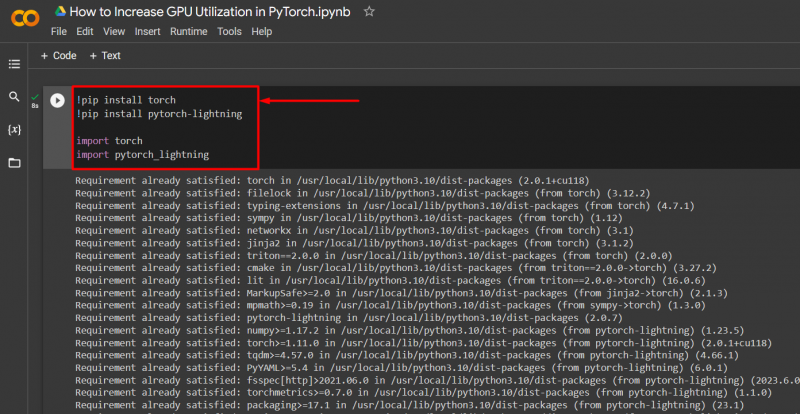

นำเข้าไลบรารีที่จำเป็นไปยังโปรเจ็กต์ PyTorch ด้วยไวยากรณ์ที่ระบุด้านล่าง:

! pip ติดตั้งไฟฉาย

! pip ติดตั้ง pytorch - - ฟ้าผ่า

นำเข้า คบเพลิง

นำเข้า pytorch_lightning

ปรับการตั้งค่ารันไทม์ใน Google Colab

Google Colaboratory เป็น IDE บนระบบคลาวด์ที่ให้การเข้าถึง GPU ฟรีแก่ผู้ใช้เพื่อการพัฒนาโมเดล PyTorch โดยค่าเริ่มต้น โปรเจ็กต์ Colab ทำงานบน CPU แต่เปลี่ยนการตั้งค่าได้

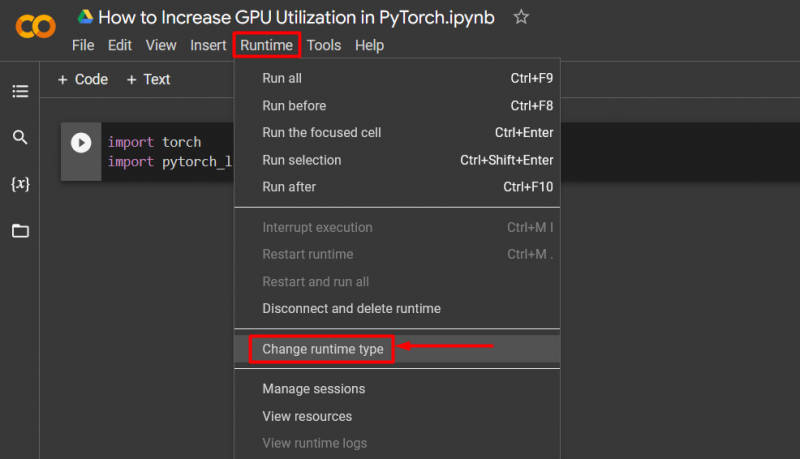

เปิดสมุดบันทึก Colab ไปที่ ' รันไทม์ ” ในแถบเมนู และเลื่อนลงไปที่ “ เปลี่ยนการตั้งค่ารันไทม์ ”:

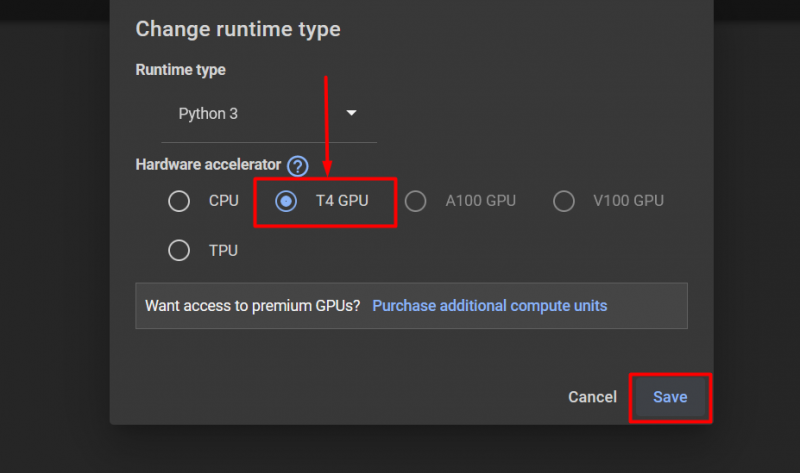

จากนั้นเลือก “T4 จีพียู” ตัวเลือกและคลิกที่ “ บันทึก ” เพื่อใช้การเปลี่ยนแปลงเพื่อใช้งาน GPU:

ล้างแคชเพื่อการเพิ่มประสิทธิภาพ

PyTorch อนุญาตให้ผู้ใช้ล้างแคชหน่วยความจำเพื่อให้สามารถเพิ่มพื้นที่ว่างเพื่อให้กระบวนการใหม่ทำงานได้ “ แคช ” เก็บข้อมูลและข้อมูลเกี่ยวกับโมเดลที่กำลังรันอยู่เพื่อให้สามารถประหยัดเวลาในการรีโหลดโมเดลเหล่านี้ การล้างแคชจะทำให้ผู้ใช้มีพื้นที่มากขึ้นในการเรียกใช้โมเดลใหม่

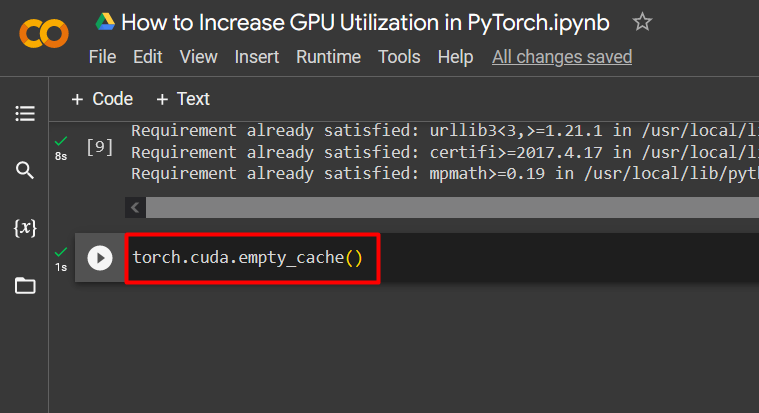

คำสั่งในการล้างแคช GPU มีดังต่อไปนี้:

คบเพลิง. แตกต่าง . Empty_cache ( )

เคล็ดลับเหล่านี้ใช้เพื่อเพิ่มประสิทธิภาพการทำงานของโมเดลการเรียนรู้ของเครื่องด้วย GPU ใน PyTorch

โปรทิป

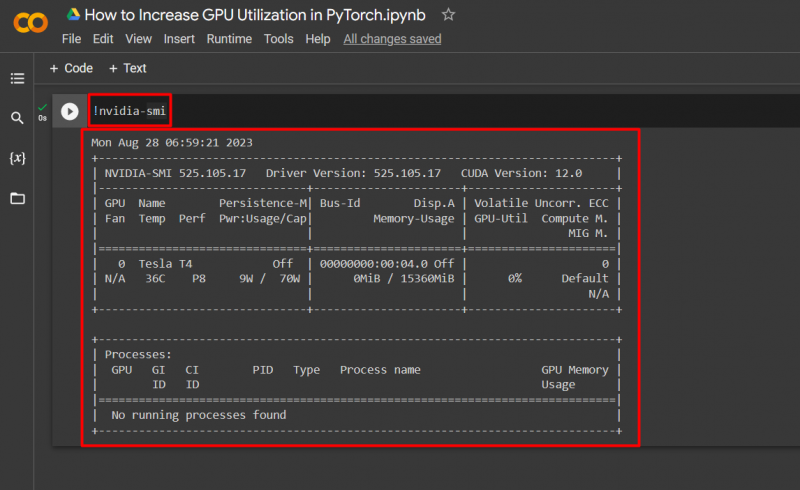

Google Colab อนุญาตให้ผู้ใช้เข้าถึงรายละเอียดเกี่ยวกับการใช้งาน GPU โดย “ NVIDIA ” เพื่อรับข้อมูลเกี่ยวกับตำแหน่งที่มีการใช้ทรัพยากรฮาร์ดแวร์ คำสั่งเพื่อแสดงรายละเอียดการใช้งาน GPU มีดังต่อไปนี้:

! NVIDIA - - ยิ้ม

ความสำเร็จ! เราเพิ่งสาธิตวิธีการเพิ่มการใช้งาน GPU ใน PyTorch สองสามวิธี

บทสรุป

เพิ่มการใช้งาน GPU ใน PyTorch ด้วยการลบแคช โดยใช้ PyTorch Lightning ปรับการตั้งค่ารันไทม์ ใช้โมเดลที่มีประสิทธิภาพ และขนาดแบตช์ที่เหมาะสมที่สุด เทคนิคเหล่านี้ช่วยให้แน่ใจว่าโมเดลการเรียนรู้เชิงลึกทำงานได้ดีที่สุด และสามารถสรุปผลและการอนุมานที่ถูกต้องจากข้อมูลที่มีอยู่ได้ เราได้สาธิตเทคนิคในการเพิ่มการใช้งาน GPU